Fator de impacto: o fetiche do cientista

21/05/13 15:56

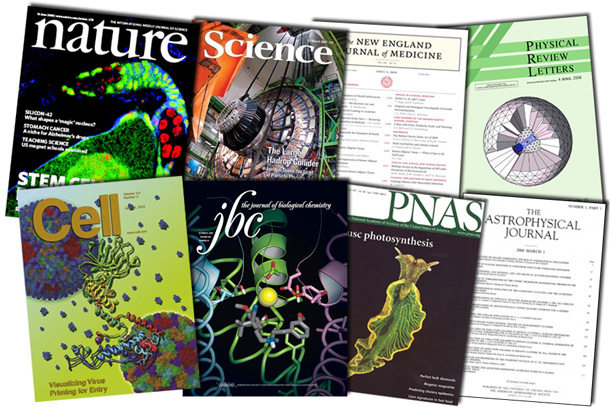

Capas de algumas das revistas científicas indexadas com maior fator de impacto (Imagem: reprodução)

POUCA COISA NO MUNDO é mais imprecisa do que a cientometria, a ciência que usa números para medir a qualidade da ciência. Essa disciplina tem seu mérito e sua utilidade, mas é vítima de uma ironia da condição humana: estudos científicos são trabalhos que buscam construir conhecimento com a maior objetividade possível, mas só podem ser avaliados com justiça quando alguém tem paciência para analisá-los um por um, subjetivamente, sem apelar demais para os números da cientometria.

Apesar de essa afirmação soar paradoxal, a maioria dos cientistas tende a concordar com ela. Os abusos cometidos contra esse princípio, porém, são tão comuns que motivaram agora uma campanha ética na comunidade acadêmica. Um grupo de pesquisadores está querendo acabar com o uso indiscriminado do chamado fator de impacto, o índice cientométrico considerado por muitos a medida da qualidade de uma revista científica.

Num manifesto batizado de DORA (Declaração sobre Avaliação de Pesquisas, acrônimo em inglês), lançado em San Francisco, um grupo de cientistas pede que o fator de impacto das revistas em que estudos são publicados deixe de ser usado em decisões importantes. O documento pede que esse índice seja ignorado em decisões sobre contratação, premiação, promoção e financiamento de cientistas.

Para entender o problema em torno do fator de impacto, é preciso conhecer um pouco melhor a dinâmica das referências que cientistas fazem uns aos outros em trabalhos científicos. A base da cientometria está na análise das redes de citações —as menções que um estudo faz a outros estudos. Trabalhos mais importantes tendem a ser mais citados que trabalhos irrelevantes, e toda a lógica da cientometria se constrói em cima disso. O que ela nem sempre leva em conta, porém, é que cientistas sabem como alavancar artificialmente as citações a seus próprios trabalhos.

Um pesquisador pode pedir a um colega que o cite para depois retribuir o favor. E se um cientista fatiar o resultado de uma pesquisa em vários estudos (em vez de publicar tudo num único trabalho mais completo), pode vir a receber mais citações. Usando essas táticas de mérito duvidoso, um pesquisador pode turbinar sua produtividade e sua aparente influência quando estas forem estimadas partir do número de citações por estudo publicado.

Há alguns métodos estatísticos para impedir que distorções apareçam, mas a eficácia de cada um depende muito da área da ciência à qual é aplicado. Algo que costuma ser aceito como um selo de qualidade de um estudo, porém, é o fator de impacto da revista em que o trabalho é publicado. O fator de impacto é medido pelo número total de citações que uma revista recebe em dois anos dividido pelo número total de artigos publicados no período.

A aceitação em um revista de alto impacto é encarada com um cartão de visitas de gala para um estudo. A disputa para entrar nessas publicações é acirrada, e os comitês que analisam os artigos submetidos costumam ser muito rigorosos. Cientistas com muitos trabalhos publicados em periódicos como “Science” e “Nature”, por fim, acabam se cacifando para ocupar cargos mais altos e receber verbas maiores.

Mas há uma coisa na ciência que é um segredo de polichinelo: a vasta maioria dos estudos publicados em revistas de alto impacto, na verdade, não é muito influente.

O “Journal of Cell Biology”, uma revista de alto impacto que se comprometeu a adotar as medidas propostas pelo DORA, explica o problema em seu editorial desta semana: “O fator de impacto de uma revista científica pode ser impulsionado por apenas uns poucos artigos altamente citados, mas todos os artigos publicados em uma dada revista, mesmo aqueles que nunca são citados, são tidos como detentores do mesmo impacto.”

O problema em atribuir importância demais às revistas em que um pesquisador publica seus estudos é que isso gera uma cultura de menosprezar outros critérios de avaliação curricular. O DORA ressalta que os resultados da pesquisa científica são muito variados e não se resumem a artigos. Uma pesquisa pode criar bancos de dados, softwares, novos materiais e métodos de pesquisa, além de servir para treinar novos cientistas.

Essa campanha ética começou no campo da biologia celular por ser uma área onde o fetiche do fator de impacto é particularmente nocivo, mas isso se estende por todas as ciências naturais. Outro problema por trás dos fatores de impacto é que áreas da ciência muito concorridas tendem a ver a formação de “panelinhas” de cientistas que dominam algumas das publicações mais disputadas. Isso não é novidade, e todo pesquisador sabe disso.

Um dos problemas apontados no manifesto é que muitos estudos preferem citar artigos de revisão no rodapé, em vez de usarem referências a descobertas originais. Isso prejudica o mérito individual de estudos realmente inovadores e faz com que várias revistas com a palavra “review” no nome adquiram impacto altíssimo.

Justiça seja feita, a culpa de tudo isso não é da cientometria. O fator de impacto foi criado para orientar bibliotecas sobre quais revistas assinar, não para avaliar a qualidade da ciência publicada nelas. A própria Thomson Reuters, empresa que faz o levantamento sobre fator de impacto hoje reconhece isso em sua definição sobre o índice. E uma das recomendações mais diretas do DORA é que revistas deixem de alardear seus fatores de impacto em suas campanhas promocionais.

Resta saber se a campanha contra o fator de impacto vai sensibilizar a comunidade científica. Se o movimento ficar restrito a uma meia dúzia de pesquisadores, instituições e publicações, aqueles que aderirem podem sair prejudicados no fim. Mas algumas grandes revistas já assinaram o manifesto, incluindo a “Science”, que publicou um editorial sobre o assunto. A “Nature” rejeitou o documento, alegando que há itens demais agrupados numa declaração só, o que generaliza demais o problema. Uma demanda do DORA claramente difícil de atender é que a Thomson Reuters abra de graça o banco de dados que usa para calcular o fator de impacto. A “Nature” se declara contrária a abusos no uso do fator de impacto, porém, e já reforçou o ponto em vários editoriais.

Agências de fomento de pesquisa, como o brasileiro CNPq, têm procurado adotar critérios mais específicos e menos cientométricos para conceder suas “bolsas de produtividade em pesquisa”. Mas isso não impede que revisores individuais deixem de ser seduzidos por fatores de impacto maiores.

Pessoalmente, tendo a concordar com alguns argumentos da “Nature” para não assinar o documento. Independentemente do fator de impacto, algumas publicações sempre terão mais prestígio que outras. E é bom que exista um mercado onde diferentes cientistas disputem espaço por mais atenção. Jornalistas sabem que a probabilidade de uma pesquisa importante sair na “Science” é muito maior do que no “Australasian Journal of Applied Nanoscience”.

Com o financiamento à ciência mundial ainda abalado pela crise, não está claro se medidas paliativas como essa vão diminuir o clima de canibalismo e de vale-tudo que está se instaurando em algumas áreas da ciência. Mas se alguém tem de sair perdedor, que pelo menos as regras do jogo sejam mais claras. O DORA tem um mérito importante nesse aspecto.

__________________________________________________________________________

Oi Rafael,

Seu texto está excelente. Sou doutorando da USP e atualmente estou fazendo um estágio sanduíche na UCLA. Eu acredito que o FI é importante, mas sinceramente não sei como desvinculá-lo dessas “artimanhas” que alguns pesquisadores usam pra tirar proveito do sistema. Talvez esse manifesto pelo menos traga mais estímulo à comunidade científica para discutir o tema e desenvolver formas mais apropriadas de avaliação de um pesquisador e das suas publicações.

Rafael, um indice que é muito robusto frente a citacao reciproca e salame slicing é o indice K: um cientista tem indice K se ele recebeu K citaçoes, cada uma delas com pelo menos K citaçoes. Neste caso, nao adianta citacoes de amigos com papers insignificantes, pois eles nao possuem K suficiente para entrar na conta. O indice K é extremamento robusto também a autocitacoes.

Para papers individuais (em vez de pesquisadores, temos: um paper tem indice K se ele recebeu K citacoes, cada uma delas com pelo menos K citacoes.

Um outro indice um pouco menos robsuto é o h: um pesquisador tem indice h se publicou h paper onde cada um deles tem pelo menos h citacoes.

Os piores indices para avaliar um pesquisador sao o FI, o N (numero de papers) e o C (numero de citacoes). Deviam ser eliminados. Já situar o pesquisador no plano K versus h é interessante: alto K e alto h sao verdadeiros positivos, baixo K e alto h sao falsos positivos, alto K e baixo h sao falsos negativos e baixo K e baixo h sao verdadeiros negativos.

Osame,

Obrigado pelo comentário. Eu não sabia como funcionava o índice K. O índice-h eu já sabia que sofria algumas críticas. Mas os índices para avaliar papers ou a produção de pesquisadores individuais, na verdade, não me parecem tão problemáticos. O que os criadores do DORA falam que tem de ser abandonado são os índices “no nível de publicação” (“no nível de journal”), como o fator de impacto. Além do fator de impacto (ISI), tem o índice do PageRank, que apresenta o mesmo problema. É natural que um índice criado para avaliar revistas não sirva para avaliar pesquisadores, mas é uma cultura que se disseminou. Pouca gente questiona o mérito de um paper que sai na “Nature” ou na “Science”, independentemente de ele ter recebido muitas citações ou não. Essa abordagem que você mencionou sobre combinar de mais de um índice é uma coisa que eles recomendam, também, porque ajuda a eliminar as distorções mais comuns.

O fator de impacto (ou H, K, C, N ou o que for) certamente é um critério impreciso e problemático, mas algum critério é melhor que nenhum critério. Agencias de fomento, pareceristas e cientistas tem necessidade de ranquear e classificar pessoas e periódicos para distribuírem recursos, e essa realidade é incotornável. Passa-se então a discutir os melhores critérios de vários pontos de vista: justiça, facilidade de cálculo, estabilidade temporal, confiabilidade e adesão. No caso do Brasil, e das Ciências Sociais mais especificamente, não conseguimos utilizar nenhum deles pelo fato dos FI serem zero. Isso torna a produção dispensável? Não. Estes artigos continuam sendo lidos, utilizados em aulas e o numero de acessos aos mesmos pode ser monitorado através do Scielo, por exemplo. O que não dá pra fazer e importar a lógica de produtividade americana (que remunera individuos) para o sistema de ensino superior público brasileiro (que remunera cargos). Nos EUA o incentivo salarial se dá via produção, e no Brasil se dá via tempo. O contraponto do DORA é pertinente e fará com que pesoas mudem de ideia, mas o indicador utilizado no ranqueamento de periodicos continuara existindo.

Jeronimo Muniz: “mas algum critério é melhor que nenhum critério”.

Não se o critério é ruim (sistematicamente produz injustiças), aí é melhor nenhum critério.

Além disso, a proposta alternativa não é nenhum critério, é buscar um critério melhor.

[]s,

Roberto Takata

Rafael, acho que vc deveria citar que a CAPES ranqueia os programas de pos graduacao usando o FI das publicacoes do programa, o assim chamado QUALIS. Imagino que aceitar o DORA significa rejeitar o QUALIS. Ou não?

Osame, eu não sabia disso. Ótima observação. Vou incluir isso no rodapé do post.

Importante nao simplificar demais a analise dos Programas de PG pela Capes. O FI e’ apenas um dos parametros usados na avaliacao dos PPG, atraves do Qualis.

Não só os autores aprenderam a alavancar seu fator h, as revistas tambem o fazem descaradamente.

Um exemplo prático: uma amiga se perguntou se eu conhecia o EUR J INFLAMM, uma revista que apresenta um fator de 5.223 mas que curiosamente não é indexada no PubMed.

Investigando a origem de tal fator de imacto no via Thomson Reuters, em poucos cliques é possível descobrir que o EUR J INFLAMM tinha de 1 a 5 citações POR ANO até 2010, quando esse numero pulou pra 220. Mas até aqui ‘tudo bem’, mesmo considerando que sem PubMed, é improvável (pra não dizer impossível) ter essa visibilidade.

Entretanto, no ‘citing journal report’, fica claro que praticamente todas essa 220 citações vem de dois journals, INT J IMMUNOPATH PH e J BIOL REG HOMEOS AG que não por acaso são do mesmo publisher (BIOLIFE SAS) do EUR J INFLAMM.

Que tal?

Rafael,

A Cientometria tem seus limites (como outras metodologias), o que não a desabona. O importante é reconhecer quais são esses limites para que a metodologia seja usada de forma correta na geração de informações confiáveis e úteis para a área de Política Científica. Outras metodologias – como a análise por pares, a análise de redes sociais e a análise de conteúdo – quando empregadas conjuntamente, podem acrescentar informações preciosas para uma montagem de um quadro mais completo sobre a dinâmica de produção científica.

Pertinente a preocupação de DORA, esse uso indiscriminado do FI, é bom que promova um debate oportuno sobre a legitimidade dele.

Rafael,

Excelente texto. E eu como bibliotecária de referência e mestre em Ciência da Informação, na qual trabalhei com comunicação científica e periódicos, conheço desse campo. Até por que adotei a bibliometria como um dos meus métodos de pesquisa, concordo com você e venho acompanhando esse debate.

Vale notar que o fator de impacto *individual* do cientista medido em número de citações aos seus artigos tem peso _zero_ nos citados critérios de avaliação do CNPq. O fator de impacto *do veículo de publicação*, contudo, que foi criado para que a CAPES pudesse avaliar a produção de programas de pós-graduação, é usado rotineiramente por ambas agências de fomento para avaliar indivíduos. Em nome da “objetividade” e como resultado das nossas políticas cientométricas mal elaboradas, conseguimos criar uma cultura nacional de publicação da pior espécie, em que aumentamos muito o número de artigos irrelevantes publicados em revistas e congressos de peso.

Nessa discussão sobre o Fator de Impacto, ressalto que ele é genuíno para o que mede. Ele não se propõe a medir o comportamento da comunidade científica, mas o resultado desse comportamento. Ele mede o quanto a comunidade científica está aceitando as “escolhas” do corpo editorial sobre os manuscritos que a revista recebe (é uma “nota” para esse corpo editorial – talvez por isso editores não gostem muito, exceto quando vão bem). Como toda medida de atividade de pessoas, esbarra em problemas. O voto popular tem também o mesmo problema (nem sempre os melhores dirigentes podem ser escolhidos; a mídia interfere demais etc.). As manipulações das revistas não são tão diferentes também das manipulações de autorias, que muita gente prefere não comentar (há pessoas sendo contratadas graças a autorias indevidas). As críticas sobre as manipulações são importantes e devem ser consideradas e avaliadas. Mas daí dizer que a cienciometria é ruim… acho que tem muita distância.

Notem também que se trata de uma concorrência entre empresas. A empresa ISI (na berlinda), a Nature (que não assina o documento DORA) e a empresa Science (que assina). Cada uma dessas empresas tem seus agregados. Notem que faz 5 anos de cálculo de fator de impacto que a Science não passa a Nature (quando antes elas flutuavam próximas entre si) e que a Nature fez marketing agressivo a partir de seu último FI.

Fora isso, voltemos à academia. Prefiro ser avaliado por voto de meus pares (mesmo que problemáticos), do que por voto de um comitê de meia dúzia de “escolhidos”. Assim, reforço aqui a importância da manifestação da comunidade acadêmica sobre a produção científica, o que é visto por meio das citações. Entendo que muitos não sabem citar e fazem isso da forma como tratam a autoria ou trocam de roupa.

Avaliação é sempre complicada, mas tentar substituir algo que está mal por algo pior é complicado. O FI, quando em escala grande (ex., 1,5 x 7, numa mesma área) reflete, para quem está acostumado a publcar, que a dificuldade de publicação é muito diferente entre esses níveis de revista (experimente e verá). Quando a diferença é pequena (ex., 1,5 x 2), não indica muita coisa. Então, dependendo da escala, não se explicam as diferenças por meio de jogadas de revistas ou desequilíbrio da comunidade “votante”. Há como usar… e há como não usar.

Avaliar desempenho científico de pessoas é bem complicado mesmo. Mas algumas avaliações qualitativas podem também travar o sistema. Se mandamos pessoas avaliarem o conteúdo de um texto, essa avaliação dependerá dos conceitos dessas pessoas, que podem apenas representar a ideia predominante num certo período. Por isso ainda prefiro avaliações baseadas na ação da comunidade (lembremos que citação significa ação; o ato de usar certa informação publicada). Não vejo que o DORA resolva a questão, mas apenas levanta problemas; e são problemas já levantados há tempo, inclusive vários deles já assumidos pelos próprios “donos’ do FI. Mas, vale o debate… e vale também ler o que escreveram as pesosas da Nature (http://blogs.nature.com/news/2013/05/scientists-join-journal-editors-to-fight-impact-factor-abuse.html?utm_source=dlvr.it&utm_medium=twitter).

Mas uma coisa é certa… ciência de boa qualidade leva a pesquisa de boa qualidade e esta tem condições e se tornar uma publicação de boa qualidade, com alguma chance de virar conhecimento científico sólido e significativo para a população humana. O resto é consequência.